În ultimele câteva luni, comunitatea inteligenței artificiale a fost străbătută de o dezbatere aprinsă declanșată de două lucrări de cercetare influente publicate de apple. Primul, illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (octombrie 2024), și al doilea, "Iluzia gândirii" (iunie 2025), au pus sub semnul întrebării presupusele capacități de raționament ale modelelor lingvistice mari, declanșând reacții mixte în întreaga industrie.

Așa cum am analizat deja în studiul nostru aprofundat anterior intitulat „Iluzia progresului: simularea inteligenței artificiale generale fără a o realiza”, problema raționamentului artificial atinge esența a ceea ce considerăm a fi inteligența mașinilor.

Cercetătorii Apple au efectuat o analiză sistematică a modelelor de raționament mari (LRM) - acele modele care generează urme de raționament detaliate înainte de a oferi un răspuns. Rezultatele au fost surprinzătoare și, pentru mulți, alarmante.

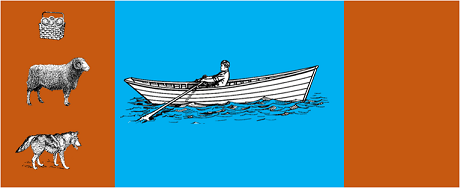

Studiul a supus cele mai avansate modele unor puzzle-uri algoritmice clasice, cum ar fi:

Rezultatele au arătat că chiar și schimbările mici în formularea problemei conduc la variații semnificative ale performanței, sugerând o fragilitate îngrijorătoare a raționamentului. După cum s-a raportat în acoperire AppleInsider, "performanța tuturor modelelor scade atunci când sunt modificate doar valorile numerice din întrebările de referință GSM-Symbolic".

Răspunsul comunității IA nu a întârziat să apară. Alex Lawsen de la Open Philanthropy, în colaborare cu Claude Opus de la Anthropic, a publicat o replică detaliată intitulată "Iluzia gândirii".contestând metodologiile și concluziile studiului Apple.

Când Lawsen a repetat testele cu metodologii alternative - cerând modelelor să genereze funcții recursive în loc să listeze toate mișcările - rezultatele au fost dramatic diferite. Modele precum Claude, gemini și GPT au rezolvat corect problemele Tower of Hanoi cu 15 înregistrări, cu mult peste complexitatea în care Apple a raportat zero succese.

Gary Marcusun critic îndelungat al abilităților de raționament ale LLM-urilor, a îmbrățișat constatările Apple ca o confirmare a tezei sale de 20 de ani. Potrivit lui Marcus, LLM continuă să se lupte cu "schimbarea distribuției" - capacitatea de a generaliza dincolo de datele de formare - rămânând în același timp "buni rezolvatori ai problemelor care au fost deja rezolvate".

Discuția s-a răspândit, de asemenea, în comunități specializate, cum ar fi LocalLlama pe Redditunde dezvoltatorii și cercetătorii dezbat implicațiile practice ale modelelor open-source și ale implementării locale.

Această dezbatere nu este pur academică. Ea are implicații directe pentru:

După cum se subliniază în mai multe perspective tehniceexistă o nevoie tot mai mare de abordări hibride care să combine:

Exemplu banal: un asistent AI care vă ajută cu contabilitatea. Modelul lingvistic înțelege când întrebați "cât am cheltuit pe călătorii luna aceasta?" și extrage parametrii relevanți (categoria: călătorii, perioada: luna aceasta). Dar interogarea SQL care interoghează baza de date, calculează suma și verifică constrângerile fiscale? Aceasta este realizată de codul determinist, nu de modelul neuronal.

Observatorilor nu le-a scăpat faptul că documentul Apple a fost publicat cu puțin timp înainte de WWDC, ridicând întrebări cu privire la motivațiile strategice. Pe măsură ceanaliza făcută de 9to5Mac, "momentul publicării lucrării Apple - chiar înainte de WWDC - a ridicat câteva sprâncene. A fost aceasta o etapă de cercetare sau o mișcare strategică pentru a repoziționa Apple în peisajul mai larg al IA?"

Dezbaterea declanșată de documentele Apple ne reamintește că ne aflăm încă în stadiul incipient al înțelegerii inteligenței artificiale. După cum am subliniat în articolul anterior, distincția dintre simulare și raționament autentic rămâne una dintre cele mai complexe provocări ale timpului nostru.

Adevărata lecție nu este dacă LLM-urile pot sau nu "raționa" în sensul uman al termenului, ci mai degrabă cum putem construi sisteme care să le exploateze punctele forte, compensând în același timp limitările lor. Într-o lume în care IA transformă deja sectoare întregi, întrebarea nu mai este dacă aceste instrumente sunt "inteligente", ci cum să le folosim în mod eficient și responsabil.

Viitorul inteligenței artificiale pentru întreprinderi nu va consta probabil într-o singură abordare revoluționară, ci în orchestrarea inteligentă a mai multor tehnologii complementare. Iar în acest scenariu, capacitatea de a evalua în mod critic și onest capacitățile instrumentelor noastre devine un avantaj competitiv în sine.

Ultimele evoluții (ianuarie 2026)

OpenAI lansează o3 și o4-mini: Pe 16 aprilie 2025, OpenAI a lansat public o3 și o4-mini, cele mai avansate modele de raționament din seria o. Aceste modele pot utiliza acum instrumente într-un mod agentiv, combinând căutarea pe web, analiza fișierelor, raționamentul vizual și generarea de imagini. o3 a stabilit noi recorduri în teste de performanță precum Codeforces, SWE-bench și MMMU, în timp ce o4-mini optimizează performanța și costurile pentru sarcini de raționament de volum mare. Modelele demonstrează capacități de „gândire cu imagini”, transformând vizual conținutul pentru o analiză mai aprofundată.

DeepSeek-R1 revoluționează industria IA: în ianuarie 2025, DeepSeek a lansat R1, un model de raționament open-source care a atins performanțe comparabile cu OpenAI o1, cu un cost de instruire de numai 6 milioane de lire sterline (6 milioane de lire sterline, comparativ cu sute de milioane pentru modelele occidentale). DeepSeek-R1 demonstrează că capacitățile de raționament pot fi stimulate prin învățare pură prin întărire, fără a fi nevoie de demonstrații umane adnotate. Modelul a devenit aplicația gratuită nr. 1 în App Store și Google Play în zeci de țări. În ianuarie 2026, DeepSeek a publicat un articol extins de 60 de pagini în care dezvăluie secretele antrenamentului și admite cu sinceritate că tehnici precum Monte Carlo Tree Search (MCTS) nu funcționează pentru raționamentul general.

Anthropic actualizează „Constituția” lui Claude: Pe 22 ianuarie 2026, Anthropic a publicat o nouă constituție de 23.000 de cuvinte pentru Claude, trecând de la o abordare bazată pe reguli la una bazată pe înțelegerea principiilor etice. Documentul devine primul cadru al unei mari companii de IA care recunoaște în mod oficial posibilitatea conștiinței sau statutului moral al IA, afirmând că Anthropic se preocupă de „bunăstarea psihologică, simțul sinelui și bunăstarea” lui Claude.

Dezbaterea se intensifică: un studiu din iulie 2025 a replicat și perfecționat criteriile de referință ale Apple, confirmând că LRM prezintă în continuare limitări cognitive atunci când complexitatea crește moderat (aproximativ 8 discuri în Turnul din Hanoi). Cercetătorii au demonstrat că acest lucru nu se datorează exclusiv constrângerilor de producție, ci și limitărilor cognitive reale, subliniind că dezbaterea este departe de a fi încheiată.

Echipa noastră de experți vă stă la dispoziție pentru consultări personalizate, pentru a vă oferi informații despre strategia de inteligență artificială a organizației dvs. și pentru implementarea unor soluții solide.